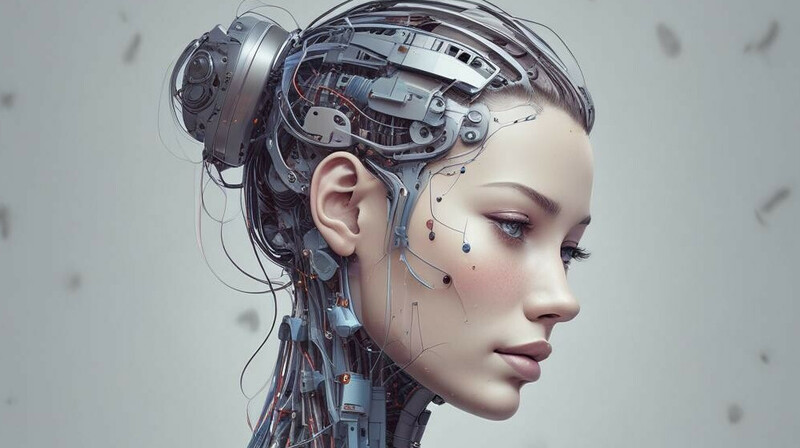

Чем опасно создание эмоционального Исскусственного Интеллекта?

ИИ уже претендует на то, чтобы читать наши чувства. Считается, что это повысит эффективность, но... Есть и риски. Стартап из Манхэттена Hume уже запустил демо-версию первого в мире голосового ИИ с эмоциональным интеллектом.

Hume распознает эмоции в голосе и реагирует с претензией на сопережевание.

Газета The Guardian пишет, что

Hume уже привлекла $50 млн инвестиций. Считается, что потенциал гораздо выше, эксперты говорят, что стартап достоин миллиардов.

Возможные области применения эмоционального ИИ варьируются от более качественных видеоигр до слежки, достойной антиутопии Оруэлла. Hume уже общается дружелюбным, почти человеческим голосом, пытаясь имитировать романтику и дружелюбие.

В интервью The Guardian эксперты говорят, что проблема Hume является проблемой человека: «Люди не пытаются показать свои чувства, они пытаются их скрыть». В то же время цель Hume понимание явных выражений - и эксперты затрудняются дать ответ на вопрос: что ИИ будет делать с нашим менее прямолинейным поведением?

Основная проблема эмоционального ИИ заключается в том, что мы не можем точно сказать, что такое эмоции. «Соберите вместе группу психологов, и у вас возникнут фундаментальные разногласия», — пишет The Guardian. К этому добавляется пресловутая проблема предвзятости ИИ.

Алгоритмы обучения ИИ хороши настолько, насколько хорош учебный материал. Но если учебный материал собран с намеренным искажением, то эта предвзятость будет закреплена в коде ИИ.

Исследования показали, что некоторые эмоциональные ИИ непропорционально приписывают отрицательные эмоции лицам чернокожих людей, что будет иметь очевидные последствия, если их использовать в таких областях, как набор персонала, служебная аттестация, медицинская диагностика или полицейская деятельность. Итак, есть опасения, что эмоциональный ИИ не работает должным образом. Но что если он работает слишком хорошо? The Guardian пишет, что возникает высокий риск манипулирования людьми ради коммерческой или политической выгоды. Эмоциональный ИИ, похоже, созрел для злоупотреблений. Разработка стратегий защиты в этой области, которые могут идти в ногу со скоростью развития ИИ, является непростой задачей.

Еще один

опасный аспект - использование эмоционального ИИ в переговорах между людьми

Уже есть тестовые разработки, которые позволяют подключать ИИ к сессиям Zoom, когда один из собсеседников использует ИИ для прочтения невербальных знаков эмоционального состояния собеседника. Это может быть исопльзовано в переговорах для повышения качества манипуляции оппонентом.

Как и в случае с любой новой технологией, влияние эмоционального ИИ в конечном итоге будет зависеть от намерений тех, кто им управляет. Как пишет The Guardian, "чтобы успешно принять эти системы как общество, мы должны понять, как интересы пользователей не совпадают с интересами институтов, создающих технологию. Пока мы этого не сделаем и не начнем действовать в соответствии с этим, эмоциональный ИИ, скорее всего, будет вызывать смешанные чувства".